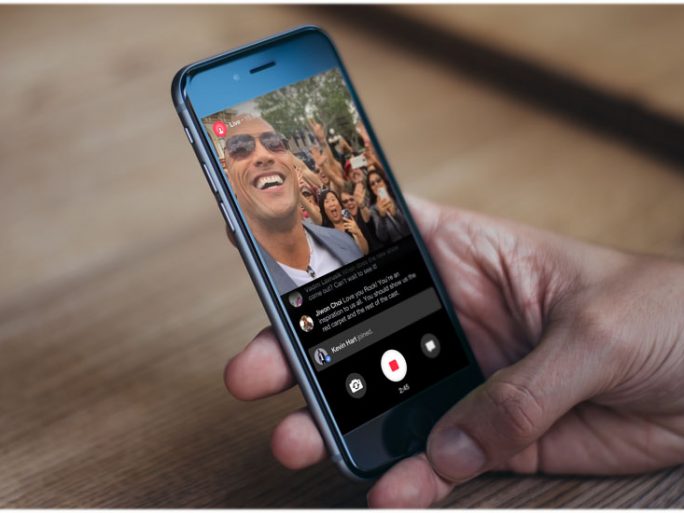

Cómo Facebook quiere acabar con los directos violentos

La red social contratará a 3000 personas para facilitar el proceso de reportar vídeos y directos violentos. Pero ¿servirá?

Cuando Facebook lanzó su servicio de vídeos en directo hace un año, hubo algo que no supo prever: que habría usuarios que lo utilizarían para emitir contenido de tipo violento. Ha habido ya asesinatos emitidos en Facebook Live y también casos de suicidios en directo y violencia sexual. Se trata, por supuesto, de casos muy sonados y Mark Zuckerberg ha decidido por fin hacer algo para evitar que ocurran cosas así.

En un post publicado esta semana en su perfil, el CEO de la red social admitía que el problema de los vídeos —en directo o no— en los que aparece alguien haciéndose daño a sí mismo o a otras personas era algo a lo que había que poner freno. «Si vamos a crear una comunidad segura, necesitamos responder rápido», decía, anunciando que durante los próximos meses iban a añadir a 3000 personas más a su equipo de operaciones de comunidad (en la actualidad hay ya 4500) para «revisar los millones de reportes que tenemos todas las semanas y mejorar el proceso para hacerlo rápido».

La intención es sin duda buena y sigue la estela de lo iniciado cuando el año pasado, tras las elecciones de Estados Unidos y tras negar en un momento que tuviesen algún tipo de responsabilidad en el tema de las noticias falsas, anunciaron que tomarían cartas en el asunto. La excusa de que son una compañía tecnológica y no un medio de comunicación tiene cada vez menos sentido.

El caso de los vídeos, no obstante, es si cabe más complicado y desde luego más delicado que el de las fake news. Cuando se trata de contenido emitido en directo la rapidez de la respuesta es clave y el propio Zuckerberg sabe que no siempre llegarán a tiempo. «Justo la semana pasada nos llegó información de que alguien en Live estaba considerando el suicidio. Nos pusimos en contacto de forma inmediata con las autoridades y fueron capaces de evitarlo. En otros casos, no fuimos tan afortunados».

¿7.500 moderadores para casi 2.000 millones de usuarios?

El problema de la medida anunciada por Mark Zuckerberg es que, al menos a primera vista, se queda algo corta. Un equipo de 7.500 personas dedicadas exclusivamente a asegurarse de que detectan y dan respuesta rápida a todos los avisos de actividad violenta, peligrosa o ilegal en la red social puede parecer mucho, pero no lo es si se tiene en cuenta que Facebook tiene casi 2.000 millones de usuarios. Y no todos están continuamente enviando avisos, pero basta con que el reporte clave de un día, ese en el que un minuto más o menos puede significar una muerte más o menos, no sea visto a tiempo para que el problema continúe.

Parece evidente que llegado el momento la inteligencia artificial sería de mucha ayuda para este tipo de casos, pero lo cierto es que, como el propio Zuckerberg admitió hace un par de meses, la tecnología está lejos de haber evolucionado tanto como para distinguir entre, por ejemplo, una escena de una película y un vídeo de un asesinato real.

Está también el tema de que la red social todavía no haya dicho cuál será el perfil específico de estos nuevos 3.000 moderadores. Como comentan en Slate, muchas compañías tecnológicas dejan estos temas de moderación en manos de trabajadores freelance en países como India, a los que además se paga muy mal. Si tan importante es, ¿por qué no tener a empleados preparados y bien cuidados? Estas tareas de moderación online, además, pasan factura psicológica a los encargados de realizarlas.

Lo de los vídeos y los directos es claramente un problema y que en Facebook lo hayan admitido y estén intentando solucionarlo es loable. De momento, no obstante, las medidas parecen quedarse cortas.