Graviton4 y Trainium2, los nuevos chips diseñados por AWS

La nueva generación de procesadores de AWS mejora notablemente la eficiencia energética y el rendimiento para dar respuesta a una amplia variedad de cargas de trabajo, incluidas las más exigentes.

Durante el congreso AWS re:Invent que se está celebrando estos días en Las Vegas, el proveedor ha anunciado la disponibilidad de su nueva generación de chips Graviton y Trainium, diseñados íntegramente por la compañía para responder a las cada vez más existentes cargas de trabajo en la nube.

Se trata del complemento ideal para las instancias tradicionales basadas en chips de Intel AMD y Nvidia, que seguirán teniendo una gran relevancia como parte de la oferta de computación de AWS, pero lo cierto es que estos nuevos procesadores ofrecerán más alternativas para los clientes del mayor proveedor de nube pública a nivel mundial.

Además, AWS reducirá su dependencia de terceras empresas a la hora de proporcionar computación en Amazon EC2 mientras aumenta considerablemente las posibilidades de escalabilidad y la relación precio/rendimiento.

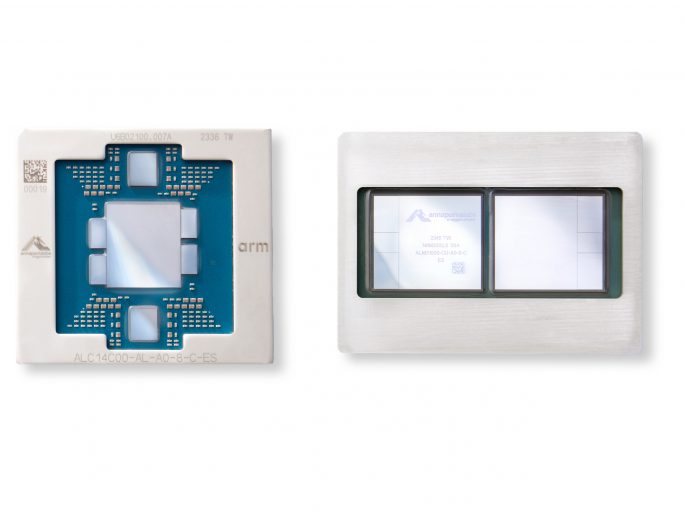

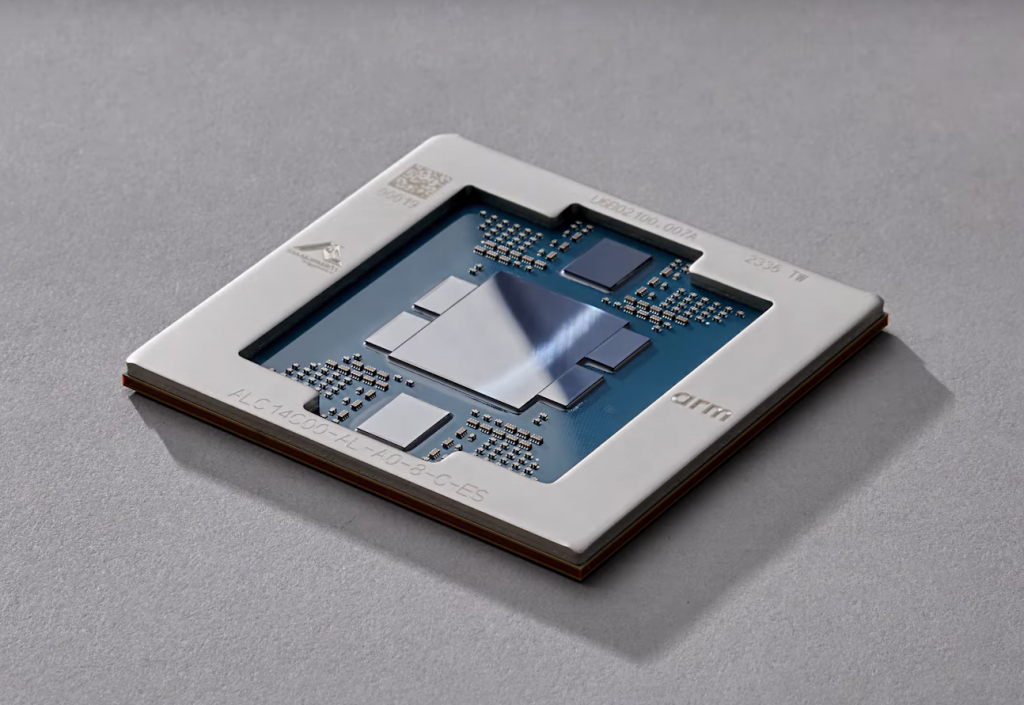

AWS Graviton4

La nueva generación de chips Graviton, basada en arquitectura ARM de 64-bit, mejora un 30% el rendimiento de su predecesora, al tiempo que aumenta un 50% el número de núcleos y un 75% el ancho de banda con la memoria de las instancias.

Hasta la fecha, AWS ha fabricado más de 2 millones de procesadores Graviton y ya cuenta con más de 50.000 clientes que han elegido estas configuraciones para sus instancias en Amazon EC2.

Desde bases de datos a servidores de aplicaciones, pasando por servidores web, analitica o ejecución de microservicios, los chips Graviton4 están diseñados para todas estas cargas de trabajo de lo más variopinto pero que cada vez requieren un mayor rendimiento mientras se reduce el consumo energético.

De forma paralela a este lanzamiento, AWS también ha anunciado las instancias Amazon R8g para EC2, compatibles con los nuevos chips Graviton4. Esta combinación permitirá triplicar tanto el número de CPUs virtuales como la cantidad de memoria disponible en cada instancia.

AWS Trainium2

Como su propio nombre indica, los nuevos chips AWS Trainium2 se han diseñado específicamente para procesos de aprendizaje de máquina y entrenamiento de modelos de inteligencia artificial, incluida la IA generativa.

AWS asegura que los procesos de entrenamiento de IA serán 4 veces más rápidos que la anterior generación de chips Trainium. Sin embargo, el dato que probablemente marque la diferencia es la capacidad de construir clusters en Amazon EC2 de hasta 100.000 chips Trainium2 para procesar de forma mucho más rápida y eficiente cualquier modelo de lenguaje grande (LLM) o modelo básico (FM) que tenga miles de millones de parámetros, lo que es cada vez más habitual en estos ámbitos de alto rendimiento.

Según la compañía, “con este nivel de escala es posible entrenar un LLM de 300.000 millones de parámetros en semanas en lugar de meses”.

AWS y NVIDIA expanden su colaboración

Sin dejar de lado el hardware para la computación de procesos relacionados con inteligencia artificial y aprendizaje de máquina, AWS también anunciaba una colaboración estratégica con NVIDIA para ofrecer nueva infraestructura, software y servicios para este tipo de cargas de trabajo.

Era el propio Adam Selipsky, CEO de AWS, el que invitaba al escenario a Jensen Huang, fundador y CEO de NVIDIA, para ofrecer más detalles sobre la expansión de la colaboración entre ambas compañías.

Como parte de este acuerdo, AWS será el primer proveedor cloud en proporcionar a sus clientes los chips NVIDIA GH200 Grace Hopper junto con la tecnología NVLink para interconectar nodos en la nube. Estas instancias de supercomputación especializadas en IA generativa, permitirán construir verdaderos monstruos con una capacidad nunca vista hasta ahora en la nube gracias a su conexión mediante la red de alta velocidad Amazon EFA.

Otro de los puntos de este acuerdo es la colaboración de ambas compañías para proporcionar NVIDIA DGX Cloud (el entrenamiento de IA como servicio diseñado por NVIDIA) en la nube pública de AWS.

Por último, conviene destacar las tres nuevas instancias EC2 que AWS comenzará a comercializar próximamente: P5e (con GPUs NVIDIA H200 Tensor Core), G6 (con GPUs NVIDIA L4) y G6e (con GPUs NVIDIA L40S), para una amplia variedad de cargas de trabajo menos exigentes pero que también solicitan grandes capacidades de computación.