En esta tribuna, Nicolas Villette, vicepresidente del sur de EMEA de HashiCorp, explica cómo la automatización y la gestión de autorizaciones impulsan la seguridad en la estrategia de Confianza Cero para las finanzas.

Desde hace un tiempo, todo el mundo habla de la Confianza cero, el nuevo paradigma de la seguridad informática. Así pues, surge la pregunta: ¿esta estrategia también es adecuada para sectores más tradicionales como el financiero? Un vistazo más de cerca muestra que la Confianza cero es perfectamente adecuada —si no urgentemente necesaria— para los retos informáticos actuales a los que se enfrenta el mundo financiero en el ámbito de la seguridad informática.

¿Qué significa «Confianza cero»?

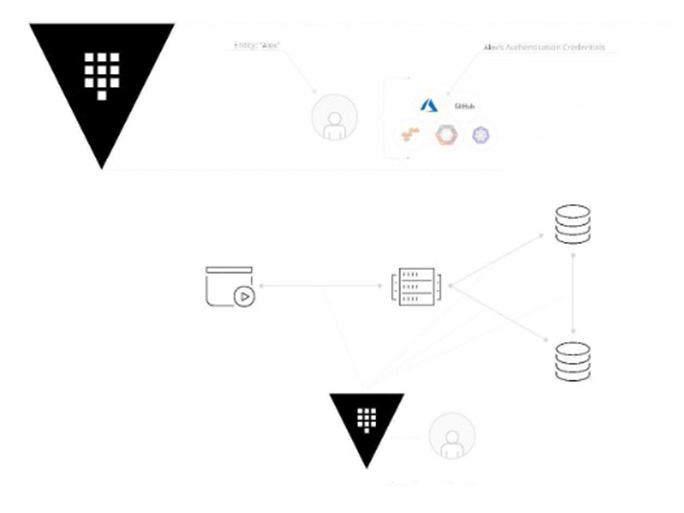

Aunque está omnipresente en la actualidad, no hay suficiente consenso sobre lo que se entiende por Confianza cero, un fenómeno que también puede observarse con el tema de «la nube». Esto hace que sea aún más importante definirlo: el concepto de Confianza cero establece que no existe la confianza basada en eventos o contactos anteriores. Básicamente, cada parte debe demostrar su identidad y, a continuación, reclamar los derechos necesarios. Esto puede parecer sencillo a primera vista, pero esta estrategia basada en la identidad no solo se aplica a las personas, sino también a las máquinas: ordenadores, usuarios, aplicaciones o cualquier tipo de servicio informático. En detalle, esto requiere mucha preparación y, no menos importante, la integración de software de apoyo, que consiste principalmente en herramientas de gestión de contraseñas, identidades o secretos similares, seguidas de un alto nivel de automatización, sobre todo en el ámbito de las infraestructuras (IaaS, PaaS, SaaS).

El principal desencadenante de la Confianza cero es la difuminación, o incluso la desaparición, de los límites entre la infraestructura informática en el propio centro de datos (CD) de la empresa y la que se encuentra en entornos de hosting o en proveedores de servicios en la nube. Por tanto, el método clásico de emplear los cortafuegos del centro de datos como un muro de castillo ya no es válido: el modelo de seguridad habitual ya no funciona porque el atacante podría estar ya en la red. Estar dentro del centro de datos de TI o detrás de sus cortafuegos ya no es suficiente para ser considerado seguro y digno de confianza.

El sector financiero como pionero

Es engañosa la impresión de que el mundo financiero está más bien orientado a lo tradicional en lo que respecta a las TI. Este sector industrial debe ser pionero por varias razones: la banca en línea tiene que adaptarse constantemente a las crecientes exigencias de los clientes y es considerada desde hace tiempo un blanco atractivo para los piratas informáticos. A través de las interfaces API, deben abrirse canales a los sistemas internos que también son cada vez más el blanco de ciberataques, por ejemplo, en el marco de las actividades de banca abierta. De este modo, se dirigen tanto al cliente final privado como al proveedor de servicios. Después de todo, para los proveedores de servicios financieros, la banca en línea ha sido el canal de comunicación y transacción más importante para el cliente final, al menos, desde la pandemia.

Otro aspecto está relacionado con el aumento del número de empleados del sector financiero que teletrabajan. Este hecho, junto con la introducción de la computación en la nube pública, ha aumentado drásticamente la superficie de ataque de la infraestructura informática que solía ser interna. Además, el cambio bastante repentino al teletrabajo ha propiciado el uso de las denominadas ofertas de SaaS. En resumen, la disminución de los límites entre la infraestructura informática originalmente interna y el entorno externo está obligando a las TI a introducir nuevos conceptos de seguridad. O lo que es lo mismo: las TI son ahora responsables de asegurar una «superred».

Asimismo, los requisitos en el sector financiero para la adopción de nuevas tendencias de TI son excepcionalmente buenos. Una mirada entre bastidores muestra que métodos modernos como DevOps, SRE y otros similares llevan mucho tiempo establecidos aquí. Esto va acompañado del uso de herramientas adecuadas, así como de métodos no técnicos. También hay que tener en cuenta las omnipresentes normativas del sector financiero. Muchas de las directrices hacen referencia al ámbito de la seguridad informática y ayudan a abordar todos los aspectos necesarios. También resulta de gran ayuda que las normativas BAIT y VAIT hayan respondido a la nueva situación en el campo de la seguridad informática. En los últimos 18 meses, ambas han ajustado y especificado sus correspondientes expectativas y requisitos.

Premisa n.º 1: gestión de secretos

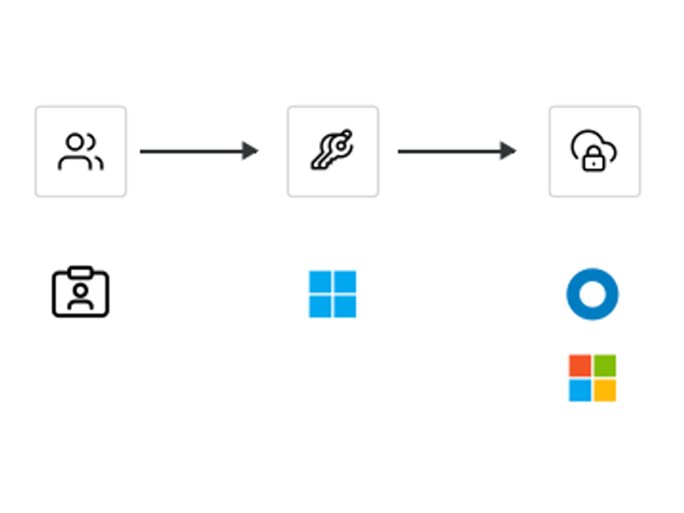

Las identidades son una parte fundamental de la estrategia de Confianza cero. Su verificación requiere algún tipo de prueba. En la vida real, se corresponde con un pasaporte o un documento de identidad. En tecnología digital, es un certificado o «conocimiento secreto». En el caso más sencillo, esto último serían las contraseñas. Aunque también pueden ser escenarios predefinidos de preguntas y respuestas o una segunda autenticación a través del teléfono móvil. En el mejor de los casos, estas pruebas de identidad también tienen fecha de caducidad, por lo que hay que renovarlas de manera periódica, ya que deben poder rastrearse en cualquier momento debido a la audibilidad. Y esto solo es la punta del iceberg. Con el auge de las estrategias basadas en API, la necesidad de contar con una sólida gestión de secretos está creciendo de manera exponencial.

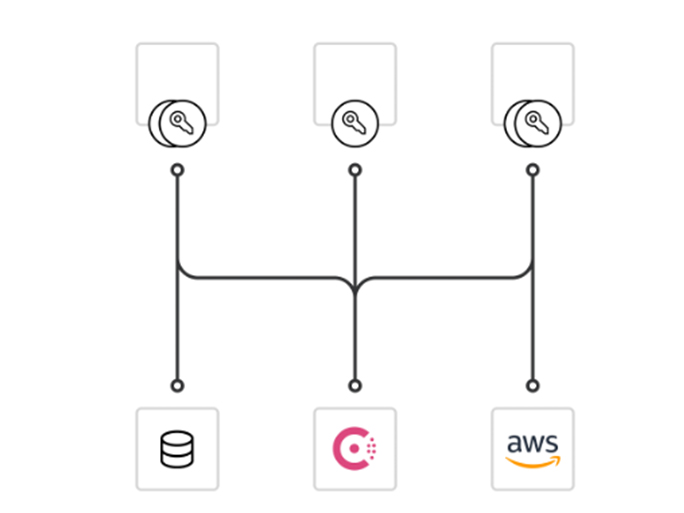

Los métodos manuales solo funcionan en pequeños laboratorios. La automatización es necesaria, pero solo contempla un aspecto de este reto multidimensional. Esto también abarca el control de acceso o el cifrado. Si deseas proteger profesionalmente tu infraestructura informática con la estrategia de Confianza cero, es imprescindible que utilices el software adecuado. En este caso, se ha demostrado que resulta eficaz el uso de soluciones maduras de diversos proveedores que ofrecen una amplia variedad de integraciones.

Premisa n.º 2: seguridad a través de la automatización

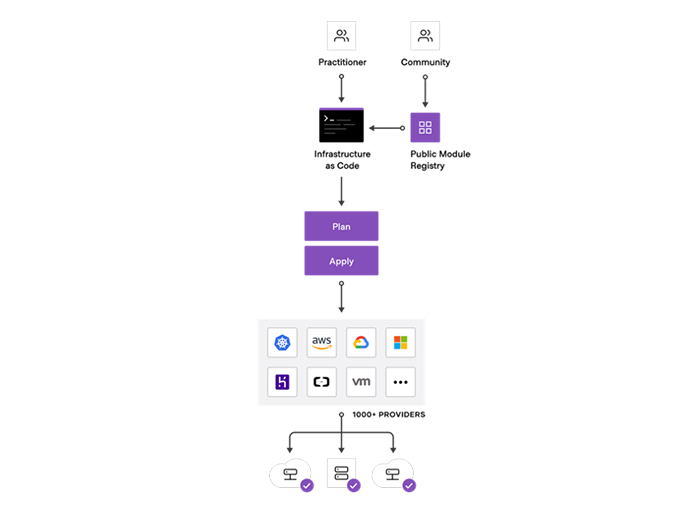

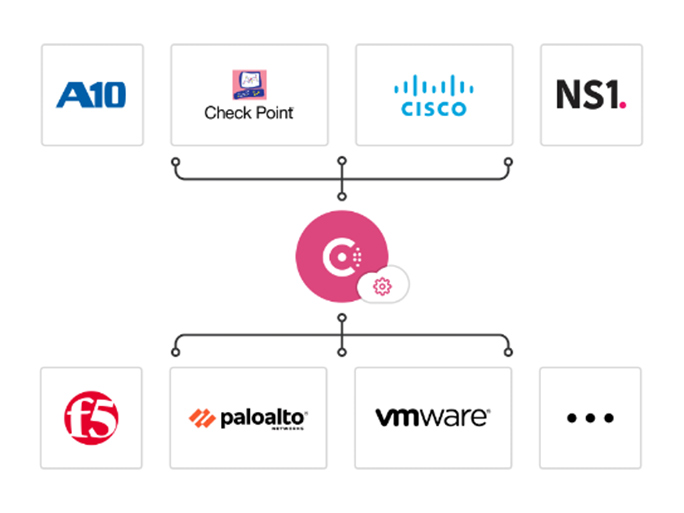

La combinación de infraestructuras informáticas locales y en la nube ha promovido la necesidad de llevar la automatización un paso más allá. En este proceso deben tenerse en cuenta tres aspectos clave. En primer lugar, la automatización de la propia infraestructura debe ser uniforme y tan agnóstica a la nube como sea posible. Con las herramientas adecuadas, pueden implantarse la reutilización y la trazabilidad en el primer paso. Asimismo, esto permite separar claramente los conocimientos prácticos (know-how) de los conocimientos factuales (know-what). La conexión en red adquiere una importancia especial, ya que requiere gestionar innumerables protocolos para la transferencia de datos y una gran variedad de productos y fabricantes.

Con la creciente aparición de aplicaciones distribuidas o incluso de microservicios, la dificultad aumenta. Es mucho más fácil eliminar el trabajo manual, implantar los cambios con mayor rapidez y usar plantillas. Para todo lo demás, no hay forma de evitar las estrategias definidas por software y la mentalidad basada en API. Esta es la única manera de hacer que la red y su estructura sean «visibles» o incluso modificables para las aplicaciones reales.

Aquí se puede tender un puente hacia el tema de la administración de identidades. Solo una red segura y robusta permite la comunicación necesaria de todas las partes implicadas. También garantiza que sea casi imposible tomar el control de esta conexión o interrumpirla.

Premisa n.º 3: gestión de autorizaciones

Además de las identidades, los permisos desempeñan una función crucial en la estrategia de Confianza cero. Los términos clave aquí son autenticación (AuthN) y autorización (AuthZ). Aunque están estrechamente relacionados, son mecanismos muy diferentes. La autenticación es la prueba de que alguien es realmente quien dice ser. Aquí es donde entran en juego las identidades. La autorización es igual de importante: ¿qué se le permite hacer a la identidad confirmada y qué se le prohíbe hacer? En casos sencillos, esto puede gestionarse mediante las denominadas listas de acceso. Pero, especialmente en el sector financiero, es necesaria una granularidad de los permisos y esto no se puede trazar en forma de lista. En principio, existen dos implementaciones predominantes para la autorización.

La primera hace referencia a un sistema que también gestiona la autenticación. El usuario recibe todo el servicio de una sola fuente y no tiene que depender de la compatibilidad de las interfaces correspondientes. Tampoco es inusual que se separen los poderes; es decir, existen sistemas separados para la autenticación y la autorización. La ventaja evidente es que, si un sistema se ve comprometido, el otro no necesariamente resulta afectado. Sin embargo, cabe destacar que los proveedores correspondientes deben garantizar por su parte la compatibilidad de las interfaces necesarias, e incluir una garantía de calidad y un plan de emergencia.

Por último, pero no menos importante: datos, datos y datos

En la estrategia de Confianza cero, no hay innumerables comunicaciones, sino aun más datos. Y en el mundo financiero, estos desempeñan una función extremadamente importante. La trazabilidad, los protocolos o incluso la seguridad de las revisiones son un componente esencial para cumplir muchos requisitos normativos. Existen dos grandes retos:

El primer reto consiste en la recopilación y el almacenamiento de una enorme cantidad de datos, incluso durante años. Igual de importante es analizar la información generada. Por razones operativas, es inevitable y necesario llevar a cabo el análisis en tiempo real. Es importante detectar y abordar los errores, ataques u otras conductas indebidas casi de inmediato.

El segundo reto hace referencia a la extracción de la información necesaria para las revisiones reglamentarias u otras auditorías. Esto se hace de forma más tradicional almacenando los datos para su revisión en el momento de la creación, y funciona bien en sistemas estáticos y cuando no hay cambios en los requisitos reglamentarios. De forma alternativa, una autoridad debidamente certificada puede realizar la extracción de la información necesaria en el momento de la revisión. Aunque permite una adaptación casi diaria con respecto a los requisitos vigentes, en realidad es mucho más difícil de aplicar.

Medidas recomendadas

No cabe duda de que cuando se trata de seguridad informática, la Confianza cero es un tema que no se puede ignorar. Debido a las normativas, el sector financiero incluso desempeña aquí una labor pionera. La infraestructura informática propia de la organización es tan importante como la del cliente o la de los empleados que teletrabajan. La industria del software ya se ha anticipado a ello: existen soluciones maduras y pruebas notables para los aspectos esenciales de la estrategia de Confianza cero. No obstante, uno de los eslabones más débiles de la cadena de seguridad es y sigue siendo el ser humano. Además de la automatización y las herramientas de pensamiento casi autónomo, solo la educación, la formación y los debates abiertos sirven de ayuda. Por supuesto, esto no solo afecta al sector financiero. Las sinergias entre sectores no solo se desean, sino que ya se están produciendo.