Todas las novedades que nos deja el AWS re:Invent 2022

Como ya es de costumbre, el congreso mundial de Amazon Web Services nos ha dejado todo un festival de anuncios en sus servicios cloud que intentamos resumir en este artículo.

AWS celebró la semana pasada en Las Vegas una nueva edición del congreso AWS re:Invent, el momento del año más importante para el proveedor hiperescalar de nube pública. Allí estuvo Silicon para traer las principales novedades a nuestros lectores, que no son pocas.

La división de servicios de TI de Amazon sigue expandiendo sus tentáculos mucho más allá de la capacidad de cómputo, almacenamiento y redes como servicio para dirigirse a cualquier ámbito de la digitalización, principalmente a todo lo relacionado a los datos que gestionan las organizaciones, ya sean públicas o privadas. De hecho, tal vez es el principal reto al que se enfrenta AWS actualmente: convencer a las administraciones públicas de la viabilidad de la nube pública para facilitar la gestión de sus datos, aplicaciones y servicios a los ciudadanos mientras se mantiene el gobierno y la soberanía de la información.

Centrándonos en las principales novedades mostradas durante estas jornadas, a continuación mostramos todo lo que ha dado de sí una semana repleta de anuncios:

Objetivo: Zero-ETL

Los grandes avances producidos durante la última década en materia de computación en la nube han generado también una enorme complejidad a la hora de gestionar todos los datos que se manejan: múltiples repositorios y fuentes de datos dentro y fuera de la nube que no facilitan su gestión, pero también su análisis a la hora de tomar decisiones en base a ellos.

Para mitigar estos problemas, AWS ha anunciado su intención de conseguir unos modelos Zero-ETL, es decir, eliminar la necesidad de Extraer (E), Transformar (T) y Cargar (L) datos entre servicios. Lo ha hecho con dos anuncios en este campo: la posibilidad de analizar los datos provenientes de Amazon Aurora con Amazon Redshift en (casi) tiempo real. Asimismo, será posible ejecutar aplicaciones Apache Spark fácilmente sobre los datos de Amazon Redshift utilizando analitica y capacidades de aprendizaje de máquina.

Amazon Datazone

Un nuevo servicio para la gestión de los datos para catalogar, descubrir, compartir y gestionar la información almacenada no solamente en las distintas instancias de AWS sino también en fuentes de terceras empresas y on-premise.

De esta forma, los ingenieros, científicos de datos, analistas o usuarios de negocio tendrán acceso a todos estos datos de forma granular y con el correspondiente nivel de privilegios para utilizar los datos y mejorar la colaboración y el descubrimiento de tendencias en base a ellos.

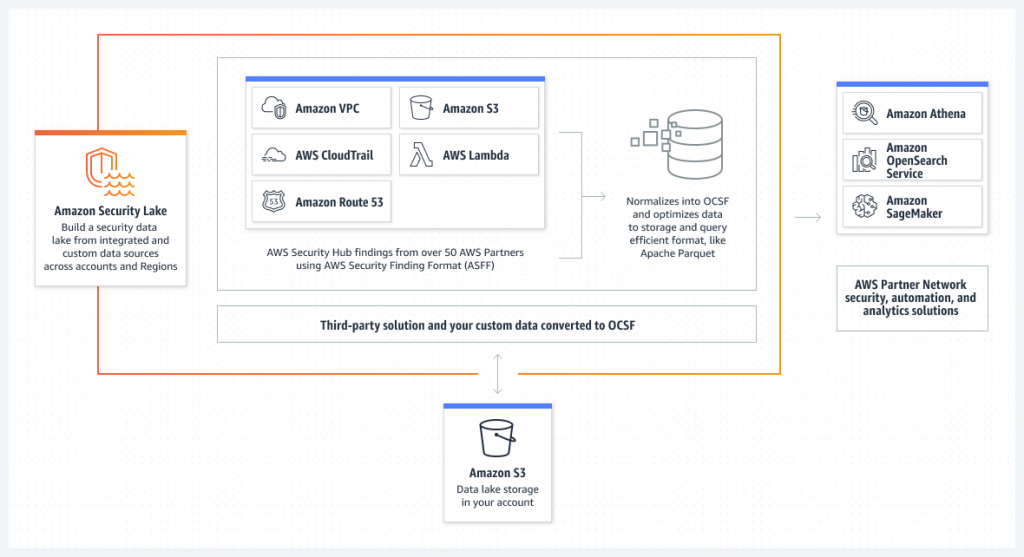

Amazon Security Lake

En ese maremagnum de información que manejan las organizaciones, se hace necesario aumentar las políticas de seguridad a la hora de acceder a ella. Amazon Security Lake se ha creado para que puedan agregar, gestionar y analizar registros y eventos sobre los datos a los que se está accediendo. Con ello, se habilita la detección de amenazas, su investigación y una respuesta frente a accidentes de forma mucho más rápida, tal y como asegura AWS.

Este servicio es capaz de realizar estas tareas a lo largo de todo el ciclo de vida del dato, lo que genera un seguimiento exahustivo y una mayor visibilidad de lo que está ocurriendo con la información.

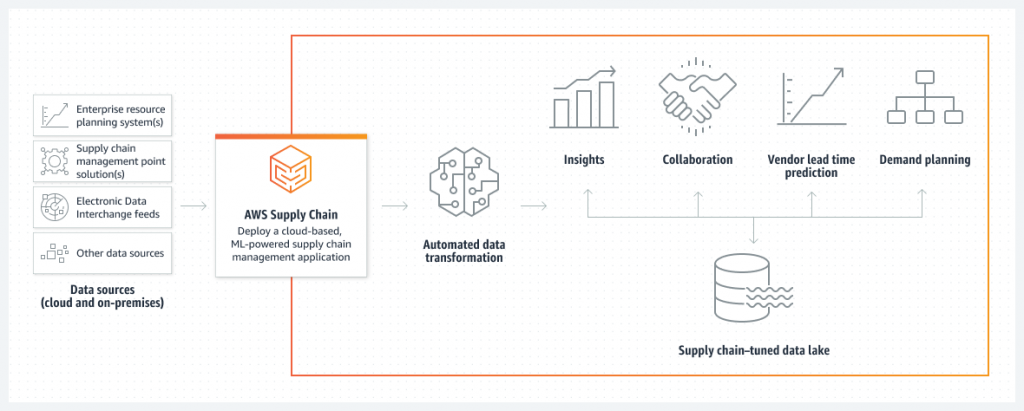

AWS Supply Chain

Amazon, la mayor compañía de comercio electrónico a nivel mundial, lleva 30 años intentando mejorar su red logística y la cadena de suministro de los productos que comercializa. Esta extensa experiencia la acaba de poner a disposición de los clientes de AWS a través de AWS Supply Chain, que busca mejorar la visibilidad de todas las etapas de la cadena de suministro gracias al conocimiento que se puede adquirir en este proceso. Con esta aplicación se facilitará la toma de decisiones y la reducción de los riesgos mientras se reducen los costes y se mejora la experiencia de los usuarios, tal y como asegura el proveedor.

Se trata de la creación de un data lake relacionado con la cadena de suministro y diversos conectores para obtener la información necesaria que, posteriormente, podrá ser procesada por algoritmos de inteligencia artificial y modelos aprendizaje de máquina, los mismos que ya utiliza la propia Amazon. AWS Supply Chain nace bajo la misma filosofía con la que nació AWS: comercializar una serie de servicios que le han permitido a Amazon llegar a lo más alto. Y, a partir de ahora, cualquier organización podrá hacer uso de esta tecnología para mejorar la puesta en el mercado de sus productos.

Amazon QuickSight

La plataforma de Business Intelligence de AWS, Amazon QuickSight, cuenta a partir de ahora con 5 nuevas funcionalidades para ayudar a las empresas a desplegar operaciones de inteligencia de negocio que puedan mejorar la toma de decisiones.

Amazon QuickSight Q mejora las capacidades para poder realizar preguntas en lenguaje natural sin necesidad de escribir consultas en código. También será posible crear y compartir de forma sencilla informes a través de cuadros de mando interactivos, o analizar y visualizar rápidamente conjuntos de datos de gran volúmen de hasta 1.000 millones de columnas. Por último, AWS habilita la posibilidad de crear, gestionar y editar de forma programática cuadros de mando en Amazon QuickSight e informes para acelerar la migración desde sistemas ‘legacy’.

Nuevas instancias en Amazon EC2

Adelantadas por Silicon hace unos días, las tres nuevas instancias disponibles en Amazon EC2 (plataforma de computación en la nube) buscan aumentar el rendimiento en diversos entornos y optimizar las cargas de trabajo.

De esta forma nos encontramos con las instancias Hpc7g con los nuevos chips Graviton3E para cargas HPC (High Performance Computing), las instancias C7gn con las tarjetas AWS Nitro v5 para mejorar el ancho de banda y las operaciones de Entrada/Salida, y las instancias Inf2 con los nuevos chips Inferentia2 para la ejecución de modelos de aprendizaje profundo a escala.

AWS Clean Rooms

De la misma forma que ocurre con las habitaciones limpias en hospitales o centros de datos, este concepto pretende habilitar características como la protección de los datos, la seguridad o el control de accesos para que las organizaciones puedan colaborar con sus socios y generar conocimiento en un entorno totalmente protegido. Con AWS Clean Rooms se evita la necesidad de duplicar información crítica para compartirla con terceras empresas en procesos de investigación y colaboración, entre otros ejemplos.

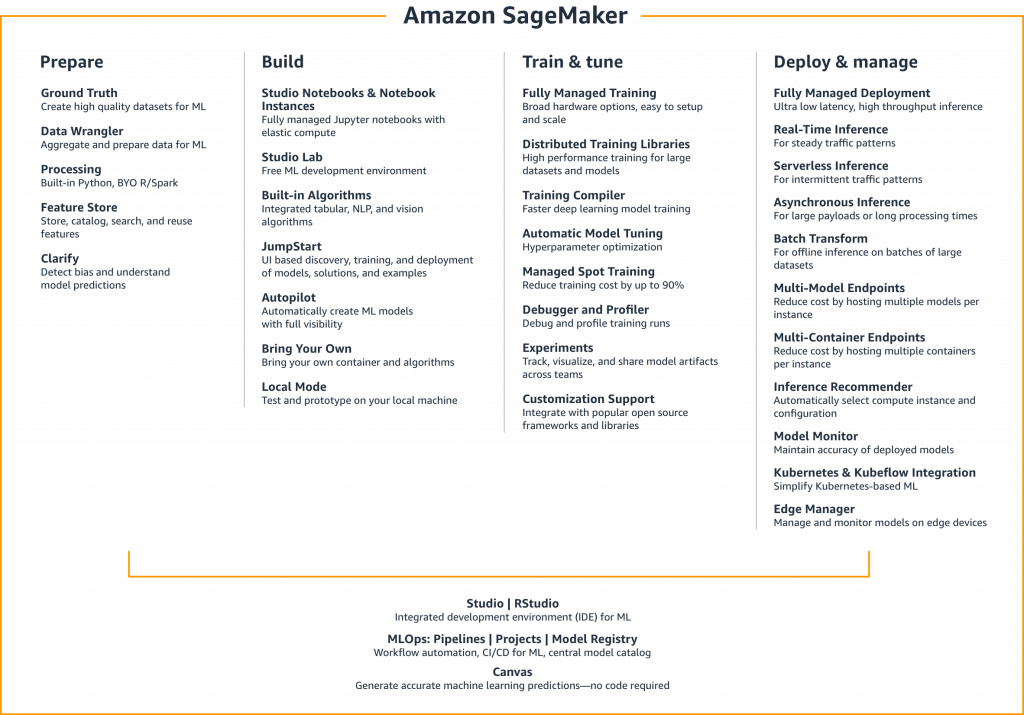

Amazon SageMaker

El popular servicio de aprendizaje de máquina de AWS implementa ahora 8 nuevas capacidades para mejorar la construcción, entrenamiento y despliegue de modelos de Machine Learning. Se trata de mejoras en un campo que está creciendo exponencialmente, tanto en capacidades como en el número de profesionales que hacen uso de la inteligencia artificial, por lo que era necesario incluir nuevos servicios como los siguientes: el control de accesos y permisos, la documentación y revisión de los modelos de información en todo el ciclo de vida del aprendizaje de máquina, unificar en la misma interfaz el control y seguimiento de los modelos, mejorar la preparación de los datos para aumentar su calidad, permitir a los científicos de datos colaborar en tiempo real o validar de forma automatizada los modelos utilizando solicitudes de inferencia en tiempo real, entre otros.

Mención destacada para el nuevo soporte de datos geoespaciales, con los que los científicos podrán desarrollar más fácilmente modelos de aprendizaje para estudiar las condiciones metereológicas, la planificación urbanística, la respuesta frente a desastres climáticos, la agricultura de precisión y muchos otros campos en los que la inteligencia artificial puede aplicarse.

Bases de datos y Analítica de datos

Otra de las áreas en las que AWS ha puesto foco a lo largo de estos años es la gestión de bases de datos y su analítica en un mundo donde las organizaciones necesitan capacidades a escala ‘petabyte’. El resultado de este esfuerzo es un mayor número de funcionalidades para sus distintas plataformas que pasamos a resumir:

– Amazon DocumentDB Elastic Cluster: El servicio de bases de datos de documentos para la administración de datos JSON a escala, que ya ofrece compatibilidad con MongoDB, es capaz de soportar millones de escrituras por segundo y almacenar hasta 2 petabytes de información haciendo uso de un sistema de almacenamiento distribuido que automáticamente divide los conjuntos de datos en múltiples nodos sin que los administradores tengan que gestionar estos procesos, hasta ahora complejos.

– Amazon OpenSearch Serverless: El servicio de búsqueda y cargas de trabajo analíticas llega ahora en versión ‘serverless’ para poder escalar estos procesos a medida que se necesite. Muchas de estas cargas de trabajo son intermitentes e impredecibles, lo que hace que su planificación sea complicada para los administradores, por lo que AWS ha incorporado sus capacidades de gestión automática de aprovisionamiento, configuración y escalado de la infraestructura que ya ofrece Amazon OpenSearch.

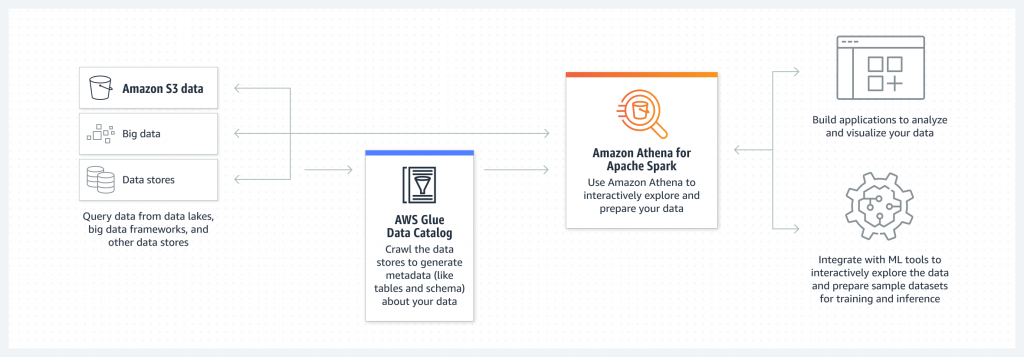

– Amazon Athena for Apache Spark: AWS añade compatibilidad con la popular plataforma basada en código abierto Apache Spark para realizar consultas interactivas de la misma forma que ya se realizan en Amazon Athena, su servicio de consultas SQL ‘serverless’. Con esta nueva funcionalidad, los usuarios no necesitan aprovisionar, configurar y escalar los recursos necesarios para realizar estas consultas que a menudo se ejecutan frente a petabytes de datos. Por el contrario, Amazon Athena for Apache Spark determina automáticamente los recursos necesarios y acelera el tiempo de ejecución y resultados de dichas consultas.

– AWS Glue Data Quality: El nuevo servicio de AWS llega para mejorar la calidad de los datos que se gestionan en múltiples fuentes de información y ‘data lakes’. Estos procesos para mantener la calidad de la información que se procesa son complejos y requieren muchos recursos, pero con AWS Glue Data Quality ya es posible medir, supervisar y gestionar automáticamente la calidad de los datos. También es posible programar su ejecución periódica a medida que cambian los datos almacenados, entre otras funcionalidades.