La gobernanza del dato en el punto de mira de los CDO

Denodo, especializada en la virtualización del dato, junto al Club CDO Spain, organizaron un evento para exponer las principales estrategias e iniciativas en el gobierno del dato.

Abrió el acto Rafael Fernández Campos, Chief Data Officer de Bankia y actual presidente del Club del CDO Spain, que presentó la evolución de esta asociación que reúne a integrantes de la profesión en un intento de aglutinar intereses y alumbrar el camino. “Hace tres años, cuando estrenábamos el cargo de CDO en las tarjetas de visita, era habitual en la conversación de ascensor que nos preguntasen que qué cosa hacíamos: ‘-Hola, buenos días’. ‘-Hola, oye ¿qué funciones te han dado?’ Y tampoco es que le pudiéramos decir mucho. Tres años después, en el ascensor, seguimos teniendo prácticamente el mismo diálogo: ‘-Hola, buenos días’, ‘-Hola, oye ¿pero qué funciones tienes tú?’. Pero ya podemos decir que si analíticas de negocio, que si calidad del dato, que si gobierno del dato, que si reportes corporativos y también informes regulatorios (RGPD). Aquellas dos funciones básicas que debe tener todo CDO -saber gestionar el diccionario de términos y saber gestionar la demanda informacional- se van quedando cortas a medida que evoluciona el mercado”.

El dirigente expuso la estrategia multidimensional del dato que están ejerciendo las compañías más punteras. “En este sentido, nos movemos en tres niveles: Como palanca clave del negocio, que la organización comprenda que el dato es un activo estratégico de valor. Como parte de la cultura de empresa, que la alfabetizacion informacional incide en la toma de decisiones basada en datos y elimina la intuición; suena poco poético, pero es la tecnología la que tiene que hacer el negocio. Como principio ético, que el dato tiene que guiar también el comportamiento de la empresa”.

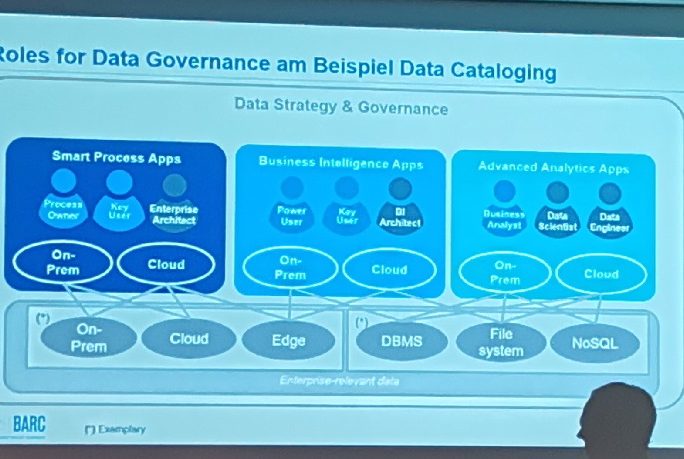

A continuación se dio paso a Timm Grosser, Head of Consulting Business Intelligence & Data Management de BARC, consultora presente sobre todo en los países europeos de habla alemana, que ha sacado su informe bienal ‘BI Trend Monitor 2019‘ que repasa el estado en el gobierno de datos en diferentes industrias y departamentos, los roles más relevantes y las herramientas del mercado. Y su primera conclusión es que el paisaje es cada vez más complejo, con aplicaciones que cada vez distinguen mejor en sus PKIs si son para los Smart Process (datos de superficie), para la Business Inteligence (almacén de datos) o para la Advanced Analytic (laboratorio de datos). Las compañías, además, comparten dos o más entornos mezclados: Corporate, On-premise, Cloud, Edge, DBMS, File System, NoSQL…

“El reto de la calidad del dato suele estar en el top de las prioridades cuando se trata de usar la información, seguido de cerca de un ramillete de problemas polifacéticos en lo organizacional, que van desde el empleo de datos inadecuados, bajo una estructura poco funcional, a la falta de información sobre el dato (metadatos), dentro de un acceso limitado”, señalaba Grosser. “Pero la tecnología no es un limitante, al contrario, puede jugar un papel fundamental en el gobierno y masterización del dato. Sin embargo, nos vamos a enfrentar a situaciones de falta de expertos para su manejo en el futuro inmediato”.

En pocas palabras, entender y trabajar con la estrategia del dato y el gobierno del dato requerirá de una ‘expertise’ y unas ‘skills’ que debe extenderse por toda la empresa. No solo hay unas obligaciones administrativas en el manejo de la información, desde la vigilancia, la protección y el cumplimiento, sino también el fomento de innovaciones para compartir y colaborar, para buscar y descubrir, para perfilar y monitorizar o para tratar y enriquecer. Además de esta pericia y nuevas habilidades, se requiere la integración de muchos componentes específicos, tanto una visión holística como la gestión de políticas. “El gobierno del dato será cada vez de más alta importancia en todos los niveles de la empresa, y asumimos que se irá incrementando en los próximos años, no solo en entornos de BI, Data Warehouse o Compliance. Sin embargo, planificadores de la gobernanza del dato tienen diferentes puntos de vista sobre cómo enfocar la gobernabilidad de datos”, añade Grosser.

Entre los datos del estudio, resaltar que solo un 4% de las empresas encuestadas han declarado que no tienen ninguna estrategia en esta perspectiva de gobernanza del dato, frente a la mitad de ellas (50%) que estiman que este año incrementarán los casos de uso, creciendo su relevancia en más departamentos. Los beneficios más impactantes del gobierno de datos se hallan en el uso más efectivo de la base de datos en un entendimiento unificado de clientes y productos, entender datos no archivados y en el soporte a la toma de decisiones.

“Más que la falta de proyectos o herramientas de administración, pesa más la falta de convencimiento de los stakeholders”, advierte el consultor de BARC. “Empresas y responsables CDO tienen diferentes puntos de vista sobre cómo enfocar la gobernabilidad de datos Entre las estrategias, en las organizaciones más establecidas prima la ejecución práctica (monitorizar la calidad de la información, fomento de la formación interna), mientras que en las recién iniciadas, prima las tareas administrativas (establecer nuevos roles y procesos, desarrollar un catálogo). En ambos casos es muy bajo aún (25%) la intención de vendérselo mejor a los stakeholders como un elemento beneficioso para el negocio. Deben anclarse en ambos departamentos de IT y negocio. Normalmente concierne más a IT, pero cuando IT se involucra en el negocio, este crece”.

Seguidamente, José Juan Sánchez, director de Marketing EMEA de Denodo que ejercía de maestro de ceremonias, dio paso al siguiente ponente, su compañero Alberto Pan: “Así como muchas empresas están triunfando en la nube y en la virtualización de las máquinas y los servidores, del centro de cálculo, Denodo es más genuina y está especializada en la virtualización del dato. El origen de esta empresa internacional (elogiada por Gartner y con más de 500 clientes por todo e mundo) también es atípico: es gallego. Su autor intelectual es Alberto, que nos habla de cómo la estrategia se ha ido focalizando hacia la inteligencia de negocio, pero también más allá de la infraestructura tradicional porque el entorno es más complejo”.

Así, el CTO de Denodo comenzó definiendo su ámbito de actuación: “Vamos a coger todos los datos relevantes para el negocio, los vamos a poner en un mismo sitio y vamos a ser capaces gracias a esto de tener una gobernanza de datos unificada. En la década de los 80, la arquitectura estaba fragmentada porque cada departamento y cada necesidad iba haciendo su camino, no había una mirada unificada. En los 90 se introduce la idea del data warehouse como un gran repositorio de los datos con un único punto de acceso, y de ahí se pasó a los data marts donde se formateaban los datos para casos específicos, todo ello fue creando más silos”, describe Alberto Pan. Esto no ha cambiado pese a los intentos posteriores de eliminar los silos con los programas ERP y el Cloud Computing, “según Gartner estamos volviendo a un escenario de fragmentación. En la última década se desarrollan los data lakes muy diferentes del enfoque tradicional, que propician la analítica del Big Data para el IoT y la escucha de las RRSS, basadas en la nube y las fuentes-como-servicio porque necesitamos una solución rápida”.

La arquitectura propuesta es el LDW, el ‘logical data warehouse’. “Inevitablemente va a haber un determinado número de sistemas coexistiendo, no hay uno que valga para todo o sea tan bueno como no necesitar el concurso de otros, señala Pan. “Denodo, mediante su software de virtualización de datos, pone encima una capa de acceso federado que permita saber dónde están guardados y de qué clase son y tener un punto único para aplicar políticas. Es el puente que aisla aplicaciones de negocio de la complejidad de abajo, y proporcionar una manera sencilla de exponer el dato de manera amigable y sin perder el control de cómo es usado, además de hacerlo de forma ágil y rápida”.

Por intentar mostrarlo de una manera resumida y clara, el sistema actúa en tres frentes, según el CTO de Denodo: “¿Cómo funciona? En la fase de conectarse a las fuentes, con un proceso de introspección para obtener metadatos y saber qué hay en cada sitio, como si fueran tablas de datos virtuales de una manera relacional. En la fase de combinación o transformación: crear un modelo semántico que construye datos como queremos presentarlos al consumidor con vistas virtuales, ni siquiera hace falta replicar los datos, siguen ahí. En la fase final de publicar: permitiendo acceder a ellos desde múltiples herramientas como interfaz SQL para bases de datos, o como RESTful para APIs, sin necesidad de añadir una línea de código”.

Entre los beneficios de las soluciones de Denodo para la gobernanza del dato, Pan destacó varias, como la posibilidad de recuperar el punto de acceso único desde una única interfaz que permite establecer políticas de seguridad de manera centralizada y más eficaz (con una granulidad a nivel de fila, columna y celda); como tener el dato siempre accesible desde cualquier puesto, independiente de dónde estén y cómo estén (data masking con enmascaración al vuelo); como recuperar la idea de la fuente canónica (versión única de la verdad con la integración con business glosary); como saber quién accede a cada dato y para qué (ver interdependencias de datos y vistas); o como confección de informes a medida alineados a través de vistas virtuales diferentes según el perfil del usuario.

De cara al futuro, “el reto mayor es el de falta de formación y habilidades para lidiar con la complejidad del almacenaje de datos, quizá por su fragmentación y dispersión en todas las capas, en especial en el modo autoservicio”, concluye Pan. “Gartner señala que en 2022, el 60% de las compañías implementará alguna forma de virtualización de datos en producción. Y antes, en 2020, ya supondrá el 45% de los ahorros en procesos de integración de datos”.

Finalmente se citaron tres casos de uso:

- Autodesk. Hace unos años cambian de un modelo de licencia perpetua a uno de suscripción, pioneros en la apuesta cloud y en la ciencia de datos, pero vieron que iban a explotar. Con Spark uno de los primeros en aplicar esta evolución de Hadoop, y enfrente cómo integrar fuentes y clientes con Denodo.

- Asurion. Venta de seguros a través del móvil con 8.000 millones de dólares de facturación, con un crecimiento tan rápido en una estructura on-premise con muchos silos, moverla con Presto a AWS y virtualizar los datos con Denodo, manteniendo por debajo las mismas aplicaciones sin cambiarlas.

- Un fabricante de chips “muy grande”. Tenían la dificultad de compartir datos entre líneas de negocio, perdiendo mensualmente hasta mil millones de dólares por falta de diálogo entre aplicaciones y datos de diversas departamentos de RRHH, finanzas o producción, solucionado a través de una arquitectura unificada REST.

Epílogo participativo

A la finalización de las ponencias hubo un pequeño debate y se dio paso a la participación de los asistentes. Abrió el fuego Eduardo Saiz de Eroski, que explicó que “llevamos tres años virtualizando, persiguiendo agilidad, fiabilidad y acceso al origen del dato. Pero sigue habiendo silos, y en las reuniones con los responsables había distintos resultados al ver los informes porque cada uno cogía los datos según podía, y eso que eran los mismos, y ahora con Denodo vamos a ser nosotros más rápidos suministrando los informes que ellos van buscando. El único fallo, que al mencionarles que era una base de datos virtual se mostraban un tanto escépticos, ahora no lo hacemos y ya está. En la capa de gobierno estamos verde no, lo siguiente, me consuela ver que el resto está igual”.

El responsable de Datos de Ferrovial Servicios, Unai Obieta expuso el caso de su empresa (solo advertir que todavía no es cliente de Denodo): “Nosotros trabajamos hace unos años con científicos de datos y con analítica de datos en AWS o Azure, pero no tenemos el esquema de un cliente final, y nos cuesta más encontrar la parte analítica porque es para procesos internos, es más descentralizado y no una misma metodología, cada piloto tiene su vida y si funciona ya lo aterrizamos, con lo que nos faltaba gobierno y nos sobran silos, excels… Ahora estamos trabajando en cuatro ejes: adquirir datos IoT; explotación de la información en dashboards (autoconsumo); y analíticas en dos ámbitos, y ha sido especialmente exitosa en nuestra plataforma de carsharing Zity de Madrid, ya que es nuestro foco analítico hacia cliente final, y otro atípico con los científicos de datos que trabajan in house con unos siete u ocho equipos federados tutelados desde IT que les proporciona herramientas para que se autogestionen y ensayan en un entorno sandbox ; cuando funciona, se comparte y se pone en la arquitectura global de Ferrovial que estamos construyendo a día de hoy”.

Otro de los intervinientes en esta última parte de la mañana fue Pablo Pellicer, Head of BI Global de Cabify, que expuso la carencia de herramientas y capas semánticas, muy pobre en comparación a otros, pero que permite llegar a insights muy rápido, aunque no tienen esa riqueza que con la virtualización se consigue. “Tenemos dos tipos de analítica, ambas separadas, pero en proceso de integración, analítica de producto y analítica de negocio. La referida a producto, al ser más tecnológica está más avanzada, y pretender ser un ‘mirror’ de empresas como Spotify, pero especialmente de Lyft (la compañía de carsharing de Google donde trabajan 300 data scientifics, mientras que en Cabify tenemos quince). La parte de negocio es más usual, con un desarrollo simple y rápido, con un 95% selfservice básico de 130 métricas. A pesar de ser pocos KPI’s, todos los días podemos hacer recap y tener respuestas a preguntas de micromovilidad, captación de usuario, conversión, etc. Algunos datos sorprendentes, sabemos por ejemplo que llevamos el doble de gente al aeropuerto de la que recogemos, se contestan a estas preguntas aunque la lectura detrás de esos datos es bastante obvia”. Otros DMM que llevan funcionando seis años posean 600 o 1.000 métricas, y eso ha explotado x10, x20 o x30 las necesidades de gobierno, y los tiempos de reacción son son cada vez más ínfimos, concluía Sánchez.